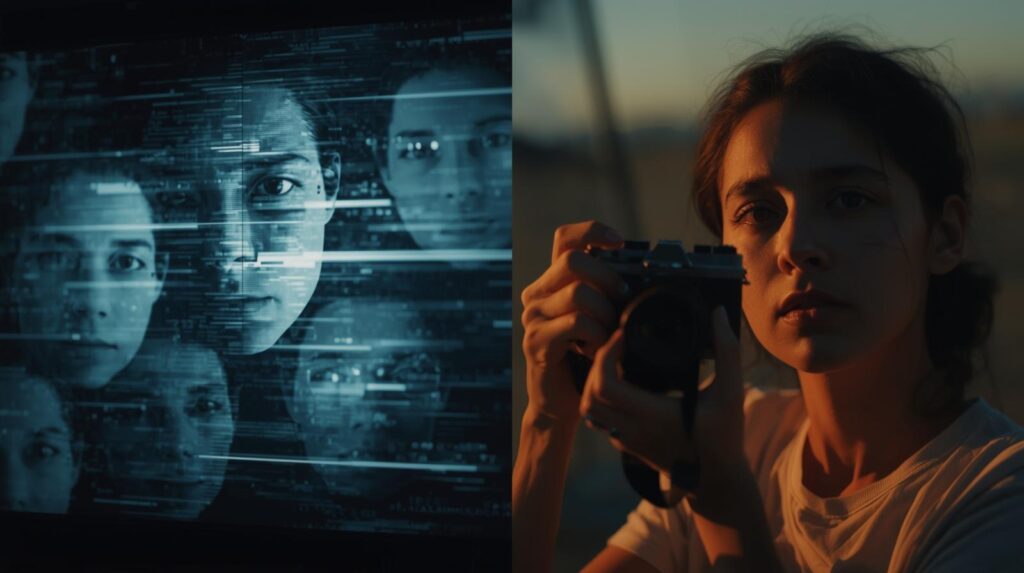

「これ、本物かな?」と思った瞬間、心が冷めてしまうあなたへ

ー AI時代の動画体験と「裏切られた感覚」の正体

はじめに

YouTubeを開いても、TikTokを眺めても、なぜか前より胸が動かない。

一瞬「すごい」と思った動画も、「もしかしてAI?」「フェイクかも」と頭をよぎった瞬間、評価がストンと落ちてしまう。

そう感じているのは、あなただけではありません。

本稿は、この「AIだと知った瞬間に冷める」という感覚的な現象を出発点に、

いま何が起きているのか、本当の問題はどこにあるのか、そしてどの方向に解決すべきなのかを考えてみます。

1. 最初の違和感:「本物だと思っていたのに」の裏切り

いま、多くの人が日々経験しているのは、とても個人的で、同時に普遍的な感情です。

たとえば実話系の感動動画、サプライズ映像、社会問題を訴える投稿。

あるいは、偶然の瞬間を切り取った日常のワンシーン

それらを「本当の出来事」だと信じて見ているときにこそ、私たちは心を動かされます。

しかし、後からそれがAIによる偽動画だったと知った瞬間、

多くの人が「内容は同じなのに急に嘘っぽく見える」「感動していた自分がだまされた気がする」と感じます。

このときに起きているのは、AI嫌悪ではなく、人間の自然な心理反応です。

感情の正体:騙された感と認知的不協和

心理学やメディア研究の分野では、こうした反応が「感情的裏切り効果」として定義されています。

人はある作品を「人間が作った」と思って評価した後で「実はAIでした」と知らされると、

作品そのものの評価を下げる傾向があることが報告されています。

これは「AIが嫌い」なのではなく、「自分の感じた感動の前提が崩れた」と感じるためです。

複数の研究では、AI生成であることを知らされていない場合、後からそれを知ると「欺かれた」という感情が生じ、

その瞬間に評価が大きく低下する傾向が確認されています。

つまり、問題の本質はこうです。

「AIだから冷める」のではなく、

「本物だと思って感動したものが、実はそうではなかった」と気づいた瞬間、感情が裏返ってしまう ということです。

2. 世界で実際に起きていること

この心理的現象は、個人の主観だけでなく、現実の環境変化によっても引き起こされています。

2-1. 誰でも「それっぽい偽動画」を作れる時代

いま、画像や音声、映像をAIで生成することは特別な技術ではなくなりました。

誰でも数分で「本物のような偽動画」をいとも簡単に作れてしまう時代です。

その結果、政治的な偽情報、個人攻撃、誤解を狙ったフェイクコンテンツが急増しており、

SNSや動画プラットフォーム上の「信頼構造」が揺らいでいます。

国際的にも「AI生成の偽映像は民主主義と社会的信頼を損なうリスクがある」と指摘されており、

2024年以降、多くの国と研究機関がこの問題への対策を急いでいるという状況です。

2-2. プラットフォームも「ラベル付け」に動き始めた

YouTubeやTikTokなどの主要サービスも、この混乱を放置していません。

YouTubeは2024年から、AIで生成・加工した映像を含む場合、投稿者に「altered or synthetic content」と表示するよう求めています。

ただし、単なる編集補助やエフェクトなどは対象外としています。(ここの線引きは難しいが・・・)

TikTokも同様に、リアルに見えるAI生成コンテンツには「AI-generated」タグを義務付け、視聴者の誤認を防ぐ取り組みを進めています。

しかし、これらの取り組みはまだ初期段階であり、視聴者が「どんな目的でAIが使われたのか」までは理解できないのが現状です。

3. 同じ「AI使用」でも目的はまったく違う

現時点で「AIを使った動画」という言葉の中には、次の三つのまったく異なる目的が混在しています。

- 完全なフェイクや欺瞞目的のコンテンツ

実在しない出来事を本物のように見せたり、人物を偽装したりするもの。 - クリエイティブやアート目的のコンテンツ

「これはフィクションです」と明示された上で制作される芸術的・実験的作品。 - 編集・補助としてのAI利用

背景除去、色補正、字幕生成など、人間が撮影した素材を整えるための技術的支援。

この三つは目的も倫理も全く異なります。

多くの視聴者は、AIそのものを否定したいのではなく、

「①のようなだましの手法」だけを拒絶したいと感じています。

しかし現在の仕組みでは、これらが一括して「AI利用」と扱われ、

結果的に②や③までが①と同列に「怪しいもの」と誤解されているのです。

4. リアルが埋もれるプラットフォームという危機

この混同が進むと、どのような未来が訪れるでしょうか。

大量のAI生成動画がタイムラインを占拠し、

実際に撮影された本物の瞬間が埋もれていく。

バズを狙ったフェイクがアルゴリズム上位を占め、

リアルな投稿が「どうせ作り物だろう」と疑われて評価されない。

調査では、SNS利用者の過半数が「ネット上の画像や動画が信頼できない」と感じており、

特に若年層では「リアルなものを見たいけれど、見分けがつかない」という回答が増えています。

本物の価値が疑われる社会では、「感動」そのものが疲弊してしまいます。

人々は感動する前に「本当かどうか」を確認し、それにより心が冷めます。

この連鎖こそが、いま多くの人が感じる「SNSがつまらなくなった理由」のひとつではないでしょうか?

5. 解決の方向性は「線引き」と「透明性」

しかし、AI技術そのものを否定するのではありません。

欺瞞的な利用と創造的な利用をどう線引きするかです。

そこが鍵になります。

YouTubeやTikTokの方針も、「リアルに見えて視聴者を誤解させるAI利用」に対しては明示を求め、

芸術・編集の範囲は許容するという方向に進んでいます。

さらに国際的には、AdobeやBBC、NYTimesなどが参加するC2PA(Content Provenance and Authenticity)という枠組みが整備されつつあります。

これは、動画や画像ファイルに「いつ・誰が・どのツールで編集したか」という情報を埋め込み、

改ざんやフェイクを防ぐ技術基盤です。

こうした仕組みが一般化すれば、視聴者は次の三つを直感的に見分けられるようになります。

- 欺瞞目的のディープフェイク(排除対象?)

- 創作・アート目的の生成(表現として尊重するし、従来以上の感動を期待)

- 編集・補助目的のAI利用(技術として歓迎・許容)

つまり、「AIを使ったかどうか」ではなく「なぜ、どの範囲で使ったのか」を明示することが重要です。

6. 物語の前提を取り戻すこと

動画体験とは、情報ではなく「物語」です。

視聴者が「これはどんな前提の映像か」を理解していれば、

AIが関わっていても感動は損なわれません。

逆に、その前提が隠されているとき、人は「だまされた」と感じ、心が離れてしまいます。

これから求められるのは、技術的な規制だけではなく、

クリエイター・プラットフォーム・視聴者の三者が「信頼の物語」を共有できる環境です。

- 「これは現実の記録です」

- 「これはAIと人間の共作です」

- 「これは実写映像をAIで編集しています」

そうした一言が添えられるだけで、視聴者の心理的距離は大きく変わります。

7. AI時代に「感動」を守るために

AI技術はもはや日常に溶け込み、完全に排除することは不可能です。

しかし、信頼を取り戻すことは可能です。

これからの課題は、

「AIを使うな」ではなく「AIをどう使ったかを正直に見せる」ことです。

- 視聴者が動画を開いたときに、「何として見ればいいのか」を直感的に理解できること。

- クリエイターが、AIをツールとして誠実に活用し、それを正々堂々と示せること。

- プラットフォームが、悪質な偽情報だけを的確に排除できること。

この三つが整えば、

「AIだと知っても冷めない」

「リアルだからこそ心が震える」

そんな健全な動画文化が再び立ち上がります。

あなたが感じた「最近つまらない」という違和感は、

AI時代の映像文化が乗り越えるべき最大の問いを、最も正確に突いています。

私たちが次に進むべき道は、AIと人間を分断することではなく、

「リアルを信じることができる世界」を、もう一度設計し直すことではないでしょうか?

参考文献・参照元一覧(2024〜2025年公表)

- Bosch, M. (2024). The effect of labeling on authenticity and engagement of AI-generated content. University of Twente. https://essay.utwente.nl/100527/2/Bosch_BA_BMS%20.pdf

- ITS Seoul Conference Paper (2024). Consumer Perceptions of AI-Generated Content and Disclaimer in Terms of Authenticity, Deception, and Content Attribute. https://www.econstor.eu/bitstream/10419/302503/1/ITS-Seoul-2024-paper-090.pdf

- Kim, D. et al. (2024). The Effects of Perceived AI Use On Content Perceptions. ACM Digital Library. https://dl.acm.org/doi/10.1145/3613904.3642076

- Marketing Insider Group (2024). AI vs Human Content: What Actually Gets You Results? https://marketinginsidergroup.com/artificial-intelligence/ai-vs-human-content-what-actually-gets-you-results-research-report/

- ITI (2024). Authenticating AI-Generated Content. Information Technology Industry Council. https://www.itic.org/policy/ITI_AIContentAuthorizationPolicy_122123.pdf

- LAVNCH (2024). Study: 90% of Viewers Concerned About AI-Generated Video. https://lavnch.com/lavnchcode/study-90-of-viewers-concerned-about-ai-generated-video/

- Pew Research Center (2025). Public Perceptions of Synthetic Media and AI Video Authenticity. https://www.pewresearch.org/

- Washington Post (2025). AI deepfake and C2PA provenance initiatives. https://www.washingtonpost.com/technology/2025/10/22/ai-deepfake-sora-platforms-c2pa/

- ProfileTree (2024). AI Transparency and Brand Trust Report. https://profiletree.com/impact-on-brand-trust/

- European Union (2025). EU AI Act – Regulation of Deepfake Disclosure. https://digital-strategy.ec.europa.eu/en/policies/european-ai-act